- 27 июля 2011 г.

Интеграция данных vs. рост объемов данных – кто быстрее?

Согласно исследованию BeyeNETWORK лавинообразный рост объемов данных и

ухудшение производительности – основные проблемы, с которыми сегодня

сталкиваются специалисты по интеграции.

По данным нового независимого исследования, объемы данных, которые будут созданы в ближайшие десять лет, затмят собой то, что было создано в предыдущие 50 лет. Но уже сейчас объемы данных таковы, что вызывает серьезные проблемы как для IT-специалистов, так и для компаний в целом.

Рост и производительность

Такой стремительный рост объемов данных связан и со все большим распространением различных современных электронных устройств, и с появлением больших объемов неструктурированных данных (электронная почта, приложения и видеоклипы). Это в свою очередь создает значительные трудности для IT-индустрии, которая должна искать способы управления этими объемами данных. Для решения этой проблемы большую популярность приобрели инструменты интеграции данных (DI). По оценке Gartner, ежегодный доход современного глобального рынка интеграции данных равен 2 млрд. долларов, и цифры продолжают расти.

Однако лавинообразный рост данных – это только одна сторона медали. Инструменты интеграции данных не поспевают за ростом требований к производительности, которые становятся все более сложными и разнообразными. Даже для тех компаний, которые внедрили основные инструменты интеграции данных и используют лучшие подходы, вопрос производительности остается крайне актуальным.

Новое исследование, проведенное BeyeNETWORK выявило ряд проблемных зон.

- Существует явное несоответствие между тем, что инструменты интеграции данных предлагают сегодня и проблемами, с которыми сталкиваются компании.

- Компании часто используют дорогие, но не эффективные процессы для решения проблем производительности, в том числе выполнение преобразований в базе данных.

- В результате компании упираются в серьезные препятствия, пытаясь достичь выполнения стратегических целей.

- Основные симптомы этих проблем следующие:

- высокая стоимость всего решения в целом;

- много времени тратится на поддержку и администрирование;

- неспособность достичь стратегических целей;

- препятствия в достижении целей бизнес-аналитики.

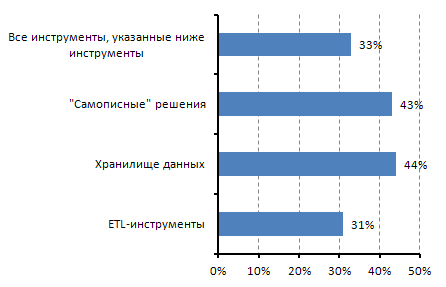

Рис. 1. Инструменты, используемые для преобразования данных

О проблеме производительности пишет в одной из своих последних статей Филипп Ховард (Philip Howard), директор по исследованиям компании Bloor Research: «Большинство платформ интеграции данных и ETL имеют всего несколько алгоритмов для выполнения операций соединения и сортировки». В результате они вынуждены различными способами оптимизировать эти процессы. В идеале, по словам эксперта, такой оптимизатор производительности должен динамически отслеживать движение данных в реальном времени и, если окажется, что существующие алгоритмы не генерируют необходимую производительность, оптимизатор автоматически будет менять схему трансформации. «Большое преимущество оптимизации, - продолжает Ховард, - в том, что ПО эффективно самонастраивается. Это значит, вам не надо постоянно настраивать ETL-процессы, следовательно, разработчикам нужно тратить меньше времени на поддержку существующих процессов, и они могут тратить больше времени на выполнение запросов пользователей».

Несмотря на активное продвижение ETL-технологии в IT-сфере в последние годы вследствие увеличения масштабов использования хранилищ данных и технологий виртуализации, IT-специалисты по-прежнему испытывают проблемы при использовании многих своих ETL-инструментов для преобразования данных. Например, менее трети респондентов сказали, что они используют ETL-инструменты для преобразования своих данных (рис. 1). Для сравнения, у намного большего процента опрошенных преобразование выполняется средствами данных баз или хранилищ данных или с помощью собственных разработок. И, хотя эти решения могут работать, они намного дороже и требуют значительного внимания со стороны IT-специалистов для достижения целей интеграции данных.

В среднем, по словам респондентов, в их компаниях объемы данных выросли на 50% за последние пару лет. Но в то же время значительно сократились технологическое окно. В результате компании оказались зажаты между лавинообразным ростом объемов данных и уменьшением технологических окон, что вызвало озабоченность производительностью многих инструментов интеграции данных, использующихся в настоящее время. Многие сходятся во мнении, что эти инструменты препятствовали, а не улучшали их возможности в достижении стратегических бизнес-целей.

Почти четверть опрошенных (23%) считают, что эти инструменты серьезно воспрепятствовали достижению поставленных стратегических целей, а почти половина (45%) признают, что эти инструменты замедлили их прогресс.

Ручной труд

Также одной из наиболее часто встречающихся оказалась проблема использования ручного программирования для решения вопросов производительности. На этом стоит остановиться подробнее.

Известно, что различные исследования постоянно отмечают удивительную живучесть ручного программирования при интеграции данных. С чем это связано?

Согласно результатам исследования, треть опрошенных (29%) программирует процессы интеграции данных вручную. По словам экспертов, это примечательно, но не удивительно. Недавнее исследование TDWI Research также подтвердило это. Интересно, что многие компании, приобретая базы данных вместе со встроенными ETL-инструментами или технологиями, все равно продолжают при этом использовать ручное программирование. Более того, такой подход оказывается популярнее предложений крупных и известных компаний.

Если верить поставщикам инструментов интеграции данных, компании давно уже ушли от ручного программирования, и избавились от старых и программируемых вручную функций. Но в действительности, отмечают эксперты, старые инструменты по-прежнему занимают заметное место в большинстве организаций. Одно из возможных объяснений заключается в том, что этим инструментам нет достойной альтернативы. Никакие другие инструменты, ни сами по себе, ни в комбинации с другими, не могут заменить выгодную и эффективную функциональность старого инструментария. Один из сотрудников индустрии на условиях анонимности так охарактеризовал эту проблему: «Зачем ломать то, что работает? Никто не хочет трогать старые приложения, пока они не выйдут из строя».

Филипп Рассом (Philip Russom), директор по исследованиям TDWI Research, считает, что «данные исследования показывают, что переход от ручного программирования к использованию DI-инструментов внешних поставщиков, один из мощнейших трендов, поскольку организации переходят на ПО нового поколения». По его словам, в большинстве случаев, компании пытаются сочетать разные инструменты, но неизбежно уходят от самописных решений. «Наиболее распространенная практика – использовать DI-инструмент для большинства решений, но дополнять его ручным программированием для восполнения тех функций, которые отсутствуют в DI-инструменте», - говорит эксперт. Он советует компаниям выбирать комплексные DI-решения, чтобы избавиться от инструментов, программируемых вручную. «Пользователи хотят уменьшить объемы ручного программирования для интеграции данных, - отмечает Рассом. – Только 18% респондентов заявили о своей зависимости от ручного программирования при интеграции данных». Он признает, что эти цифры кажутся небольшими в сравнении с результатами других исследований TDWI. В любом случае большинство компаний ожидают, что избавятся от зависимости от ручного программирования в ближайшем будущем. «Доля ручного программирования упадет до 1%», - прогнозирует Рассом.

Производительность и экономия средств

Вопрос ручного программирования также связан с проблемой производительности. Примечательно, что даже проблема номер один – затраты на приобретение или использование DI-инструментов – может рассматриваться как продолжение проблемы производительности, поскольку она часто требует ручной настройки этих инструментов или привлечения внешних консультантов для повышения их производительности.

Побочным эффектом всего этого становится снижение способности IT-сотрудников своевременно предоставлять ценную и точную информацию для ключевых потребителей информации. 58% опрошенных признают, что их IT-специалисты тратят большую часть времени (57%) на административные и организационные задачи, а на новые проекты приходится только 43% времени.

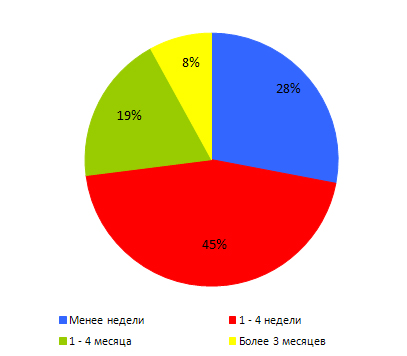

Еще один серьезный недостаток ручного программирования — это затруднения в составлении отчетности. Даже специалисты по интеграции данных признают, что сталкиваются с серьезными трудностями при создании новых отчетов из данных, которые еще не загружены в их хранилища данных. В теории, это важная область, где современные и мощные инструменты интеграции данных должны использовать ETL-технологию для сбора, нормализации и анализа данных и последующего составления отчетов в удобных форматах. Так, четверть респондентов заявила, что у них уходит более месяца на составление отчетов с использованием данных, которые еще не загружены в хранилища данных. Это очевидное и шокирующее открытие, учитывая, что все эти компании инвестировали в свои хранилища данных и инструменты интеграции данных.

Рис. 2. Сколько времени требуется на разработку отчетов при использовании данных, которые не загружаются в хранилище данных

Экономические последствия такого негативного влияния проблемы производительности инструментов DI очевидны и велики. Даже если бы IT-специалисты тратили 43% своего времени на административные и организационные задачи, а 57% на разработку новых инициатив, а не наоборот, как сейчас, финансовая отдача была бы колоссальна, отмечают эксперты.

Заключение

Объемы данных растут лавинообразными темпами. Управление этими данными становится все более и более серьезной проблемой. Инструменты интеграции данных, которые обрели заслуженную популярность в решении многих проблем, уже с трудом справляются с ростом объемов данных. В первую очередь озабоченность вызывает их производительность. Пытаясь решить этот вопрос, многие IT-специалисты обращаются к ручному программированию и доморощенным решениям, но они вряд ли смогут помочь, считают эксперты. IT-специалисты нуждаются в DI-инструментах, которые могут предложить необходимую производительность, позволяющую обеспечить сложный анализ данных в реальном времени и интегрировать все необходимые данные.

Публикации

- Стивен Свойер. Для интеграции данных производительность – новое требование (Stephen Swoyer. For Data Integration, Performance is the New Mandate). 15 июня 2011 г.

- Отчет об исследовании Beye NETWORK. Для интеграции данных производительность – новое требование (For Data Integration, Performance is the New Mandate). 2011 г.

Автор: По материалам зарубежных сайтов