- 22 августа 2013 г.

Практический подход к обеспечению качества данных

В статье рассматриваются практические аспекты сверки данных, даются

рекомендации по повышению качества данных.

Общая задача любой организации заключается в создании среды «выверенной информации», что означает высокое качество данных и точную информацию, синхронизированную при наличии рисков или требований. Выверенная информация означает высокое качество и релевантность данных, «одну версию правды» и точную информацию.

Качество и согласованность данных становится ключевым вопросом, особенно при интеграции данных из различных источников в центральное корпоративное хранилище. Поэтому прежде чем загружать данные в целевую систему, важно удостовериться, что данные источника имеют высокое качество, а процесс извлечения, преобразования и загрузки (ETL) безотказен. Однако, в реальности подобный идеальный сценарий редок, и нет никакой гарантии, что ETL-процесс всегда приносит точные данные. Ниже перечислены некоторые проблемные места:

- Во время первоначальной разработки ETL-процессов процессы загрузки данных проходят тщательное тестирование, а данные согласовываются, однако это выполняется единожды, и дальнейшее качество данных ничем не обеспечивается.

- Ответственность за качество данных возлагается на бизнес-подразделения, ошибки выявляются при обнаружении значительных расхождений в отчётности.

- Бизнес-пользователи теряют доверие к качеству данных.

- IT-отдел не имеет представления о качестве данных.

Для того, чтобы решить эти проблемы, их следует разделить на две категории – качество данных и сверка данных.

Качество данных

С точки зрения стратегии качества данных общей рекомендацией будет наличие чётко определённых процессов обеспечения качества данных и создание наборов инструментов, гарантирующих следующие результаты:

- Панели для мониторинга за качеством данных, которые помогают сотрудникам, использующим данные в своей повседневной работе, и специалистам IT-поддержки в оценке качества и применении простых правил очистки и проверки данных.

- Стандартизация, анализ, очистка, улучшение, проверка и геокодирование данных (в соответствии с бизнес-требованиями) для улучшения и обеспечения надлежащего качества данных.

- Оперативное определение и выявление несоответствия в данных между системами.

- Формализация процесса согласования данных – уверенность в том, что выверка выполняется в соответствии с графиком или ситуативно.

- Прозрачность и видимость процессов согласования данных и их результатов.

- Повышение доверия бизнес-пользователей к качеству данных - решения принимаются с полной уверенностью в данных основых систем.

Основной подход

Рекомендуется сформировать стратегию управления изменениями, чтобы выявить и включить экспертов по сопровождению данных в корпоративную структуру управления данными. Это поможет уполномочить специалистов по сопровождению данных принимать меры для улучшения качества данных в предметных областях, за которые они ответственны. Некоторые из ключевых обязанностей этих сотрудников:

- Контроль за действиями по обеспечению качества данных посредством определения показателей качества данных, правил проверки, осуществления этой проверки и мониторинга с помощью инструментов и процессов профилирования данных.

- Расширение возможностей управления данными, политик или стандартов для обеспечения надлежащего внесения, использования и преобразования данных.

- Обеспечение бизнеса соответствующей информацией о проблемах с доставкой или качеством исходных данных.

- Координация и совместная работа с прочими специалистами, ответственными за сопровождения данных, для нужд корпоративного управления информацией.

Основные задачи

- Создание культуры, предполагающей приоритет качества данных.

- Применение политик и стандартов обеспечения качества данных в рамках всей организации.

- Обучение персонала самым эффективным практикам обращения с данными и обеспечения их качества.

- Разрешение вопросов и споров в рамках соглашений об уровне обслуживания.

- Инструмент, дающий представление о данных для рассмотрения и анализа показателей качества данных.

Инструментарий обеспечения качества данных

Инструмент профилирования и проверки качества данных для специалистов сопровождения данных, бизнес-пользователей и групп IT-поддержки - это способ измерения и улучшения качества данных в рамках всей компании. Он поможет пользователям получить информацию об их данных с помощью информационных панелей, анализировать бизнес-правила и улучшать общее качество данных.

Сверка данных

Подходом к получению выверенной информации может быть согласование показателей, что гарантирует непротиворечивость данных, перемещаемых между исходной и целевой (BI) системами. Сверка данных с показателями в источнике позволяет убедиться в целостности загруженных в систему бизнес-аналитики данных. Например, сравнение результирующих показателей в BI-системе и аналогичной информации в исходной системе.

-

Как правило, рекомендуется сформировать процесс и соответствующий набор инструментов для сверки, которые дадут следующие результаты:

- Быстро выявляются несоответствия данных между системами.

- Процесс сверки формализован и автоматизирован, что гарантирует последовательное и частое проведение сверок.

- Прозрачность и наглядность процессов и результатов сверки.

- Укрепление общей уверенности пользователей – решения принимаются на базе полностью достоверных данных.

Данные, которые предполагается сверять, должны быть отобраны в соответствии со следующими факторами:

- Риск для качества данных:

- Сложность процесса извлечения.

- Необходимость постоянного вмешательства человека.

- Количество изменений в стандартном процессе извлечения.

- Процесс загрузки (инкрементальная или полная загрузка).

- Частота изменений бизнес-правил и проверок

- Возможности для выполнения сверки:

- Уровень самостоятельной настройки и сложность преобразования данных.

- Объёмы данных.

- Негативное влияние неточных данных на бизнес

Важность перечисленных факторов можно ранжировать как низкую, среднюю и высокую.

Для оценки факторов риска каждого показателя во время совещаний по обсуждению требований должен быть сформирован перечень оценочных вопросов. Если результат оценки будет превышать размер погрешности для факторов высокой, низкой и средней важности, этот показатель можно рекомендовать для сверки. Область применения может быть расширена центром компетенции в бизнес-аналитике, если возникают проблемы со сверкой в проблемных зонах.

Основной подход

Оповещение о проблемах со сверкой данных:

- При определении проблемы во время сверки данных группе техподдержки должно быть отправлено уведомление, чтобы они могли приступить к решению проблемы и проинформировать сотрудника, использующего данные в своей повседневной работе, о несоответствиях в отчётности.

Частота сверки данных:

- Однократная: должна выполняться по необходимости (например, при тестировании, планировании подготовки к продуктивному старту, предварительном запуске).

- Запланированная: должна выполняться по расписанию (ежедневно, еженедельно, ежемесячно и т. п.).

Уровень данных для сверки:

- Сверка данных может потребовать значительных системных ресурсов, если не определены необходимые ограничения уровня агрегирования данных. Рекомендуется выполнить следующие шаги, чтобы сверить данные на разных уровнях:

Шаг 1 – Сверить данные на высшем уровне агрегации данных (например, на уровне корпоративного кода).

Шаг 2 – Если предыдущий шаг не предоставил требуемой информации, данные следует сверить на среднем уровне агрегации (например, бизнес-подразделения) с дополнительными критериями отбора.

Шаг 3 - Если предыдущий шаг не предоставил требуемой информации, данные следует сверить на низком уровне агрегации (например, документа) с дополнительными критериями отбора.

Основные задачиУсилия по реализации сверки данных могут зависеть от сложности данных, количества исходных систем и сверяемых показателей. Поэтому рекомендуется определить приоритеты для показателей исходя из бизнес-потребностей.

Время обработки в значительной степени зависит от объёма данных, которые должны быть считаны базой данных и переданы; предпосылкой к использованию этого процесса является то, что пользователи устанавливают значимый набор фильтров, призванных минимизировать объём передаваемых данных. Качество данных в исходной системе тоже является фактором, требующим сверки данных. При невысоком качестве данных сверка не добавит им ценности.

Эксплуатационная технологичность и пригодность, разработка сверки для проблемных областей – это ключевые вопросы, требующие внимания со стороны специалистов технической поддержки.

Инструментарий для сверки данных

Основные факторы для выбора инструмента для сверки корпоративных данных должны быть основаны на вышеупомянутом основном подходе и должны иметь следующие особенности:

- Единая система сверки, удовлетворяющая нужды всего предприятия.

- Пользователи должны с лёгкостью конфигурировать простые и сложные сценарии сверки.

- Сокращённый цикл исполнения сложных бизнес-сценариев.

- Обработка больших объёмов транзакций в относительно малые промежутки времени.

- Повышение операционной эффективности – инструмент сверки должен позволять оперативно мониторить, отслеживать и изучать процессы сверки между несколькими источниками.

В целом, и инструменты обеспечения качества данных и сверка данных позволят предприятию повысить качество данных, и что более важно улучшить уверенность бизнес-пользователей в целостности и точности данных.

Качество данных на практике

Актуальные проблемы качества данных хорошо иллюстрируют результаты исследования, проведённого компанией Ernest & Young среди финансовых учреждений и затрагивающего вопросы эффективности организационных и технологических функций департаментов банковской отчётности.

Как известно, Федеральная резервная система США требует предоставления гораздо более детальной информации, чем подразумевает уровень, достаточный для подготовки финансовой отчётности для Агентства по регулированию деятельности финансовых институтов (FINRA, Financial Industry Regulatory Authority) или Комиссии по ценным бумагам и биржам (SEC, Securities and Exchange Commission). Регуляторы ожидают, что банковские учреждения будут вести необходимые атрибуты данных и информацию транзакционного уровня. Результаты исследования демонстрируют, что большинство финансовых институтов борются с проблемами качества и целостности данных. В последние несколько лет Федеральная резервная система сократила время на подачу регуляторной отчётности, а требуемая информация более чем удвоилась. Это создало целый спектр задач, в том числе и необходимость в обогащении данных и внесении корректировок в исходные системы.

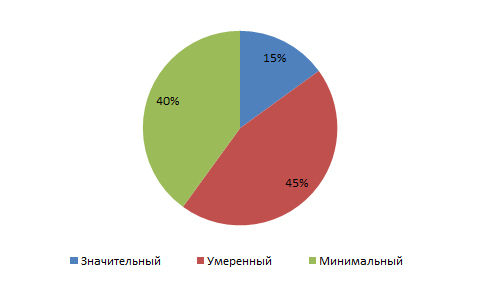

Внесение корректировок требует временных затрат, в результате увеличивается продолжительность подготовки регуляторной отчётности. Так, комментируя качество данных, используемых для регуляторной отчётности, 60% респондентов отметили, что после закрытия бухгалтерских книг им приходится вносить умеренные и значительные корректировки в данные перед подачей отчётов (см. рис. 1).

Рис. 1. Объем корректировок, вносимых в данные

Наиболее распространённые виды корректировок, упомянутые респондентами – это реклассификация (57% опрошенных) и корректировки после закрытия бухгалтерских книг (65% опрошенных). Заметное большинство вносит коррекции вручную - непосредственно в инструменте для подготовки регуляторной отчётности или в электронных таблицах, а не изменяют данные в исходных системах.

Регуляторные отчёты зачастую компилируются из данных с нескольких источников. Сверка обеспечивает уверенность руководства в том, что обеспечена полнота данные. Аналитика помогает проверить, что изменения в данных приемлемы, и выделить неожиданные аномальные отклонения, требующие более глубокого исследования. Эти элементы управления важны для определения, эскалации и разрешения проблем.

На вопрос об основных выверках, проводимых при подготовке регуляторной отчётности, 70% респондентов сообщили, что проводят сверку между регуляторной и финансовой отчётностью. Выяснилось, что это основная сверка, проводимая банковскими учреждениями, которая выполняется зачастую выполняющаяся вручную.

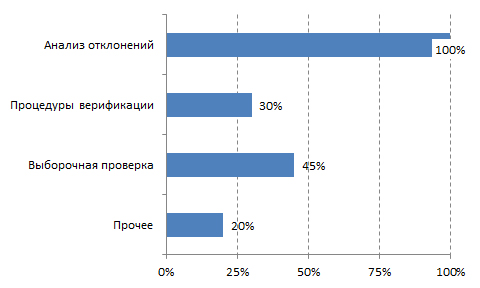

Говоря об аналитических процедурах, проводимых для обеспечения полноты и точности регуляторной отчётности, 100% участников опроса назвали анализ отклонений, а также выборочную проверку (рис. 2).

Рис. 2. Аналитические процедуры, применяемые для обеспечения полноты и точности отчётности

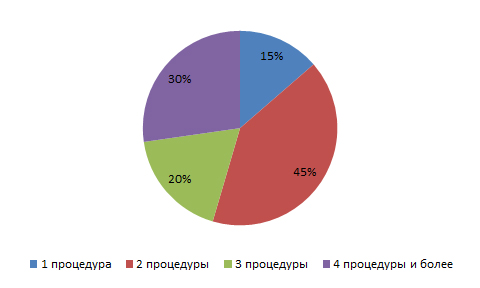

Выяснилось, что 45% респондентов выполняли лишь одну аналитическую процедуру для обеспечения полноты, точности и обоснованности результатов отчётности. И только 5% опрошенных применяют четыре и более аналитических процедур.

Рис. 3. Количество проведённых аналитических процедур

Публикации

- Намит Раман (Nameeth RAMAN). Подход к качеству корпоративных данных и их сверке (An Approach to Enterprise Data Quality and Data Reconciliation), 25 июля 2013 г.

- Исследование компании Ernst & Young «Установка темпа изменений» (Setting the pace of change), 2012 г.

Автор: По материалам зарубежных сайтов